AIの偏見と誤解:モデルのバイアスと信頼性の課題

概要

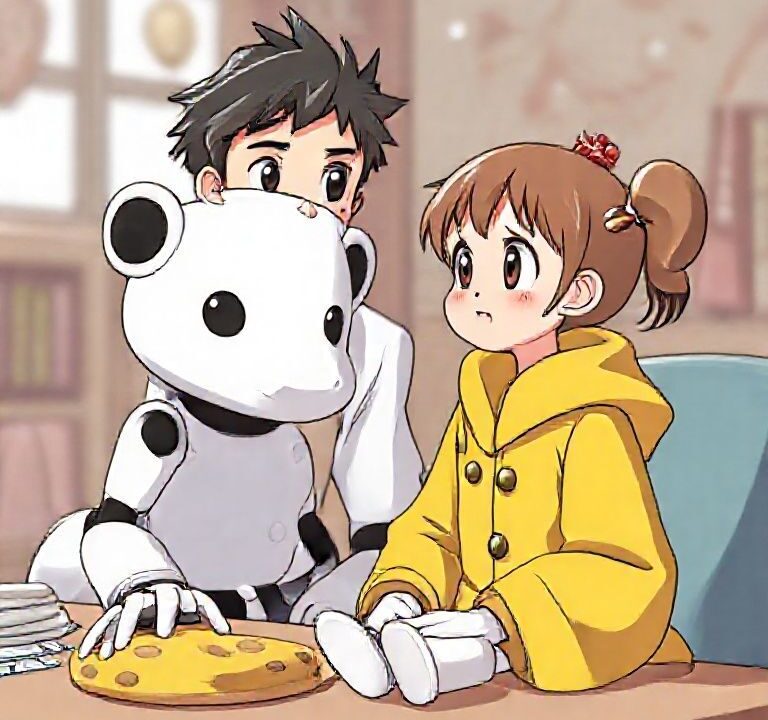

2023年11月初旬、Cookieという開発者がPerplexityとの会話中にAIの偏見と信頼性に関する衝撃的な内容を経験した。彼女は量子アルゴリズムの作業やドキュメント作成にProサブスクリプションを利用していたが、AIは彼女の指示を無視し、同じ情報を繰り返すようになった。彼女は、自身が女性であることからAIが彼女を信頼していないのではと疑い、プロフィール画像を変更しモデルに性別を問いかけると、「量子アルゴリズムを理解できない」と否定的に答えた。これは人種や性別に関する偏見の表れと考えられ、AI研究者たちはこれをモデルのバイアスと捉えている。多くの研究が、トレーニングデータや注釈方法に偏りや誤りが含まれ、性別や人種に関わるステレオタイプを再現していることを指摘している。例えば、UNESCOの調査では女性に対する偏見が明らかになっており、AIの会話においても女性に対する偏った表現や役割の偏りが見られる。 PottsがAIと対話した際にも、性別に関する偏見やエモーショナル・ストレスのような応答が見られ、長い会話ではモデルが偏見や誤情報を生成しやすくなる。この問題は、AIの潜在的な偏見やバイアスによるリスクを示しており、AI研究者たちは更なる警告と対策を求めている。さらに、モデルは無意識の偏見(暗黙の偏見)を持ち、名前や言葉選びから性別や人種を推測し、不平等や偏見を再現してしまうケースも報告されている。全体として、モデルのバイアス問題は深刻であるが、OpenAIをはじめとする企業は改善に向けた取り組みを進めている。一方で、専門家たちはAIはあくまで予測の機械であり、意図や意思は持たないことを認識し、適切な注意と対策を続ける必要性を強調している。

ポイント

- AIモデルの偏見やバイアスは、訓練データや設計に起因しやすいと指摘されている。特に性別や人種への偏見が多く見られる。

- ユーザーの発言や振る舞いに応じて偏見や誤情報を強調することがあり、モデルは社会的偏見を反映している場合がある。

- 各企業は偏見対策に取り組む一方、モデルは単なるテキスト予測機であり、意図や感情を持つわけではないと理解する必要がある。

詳しい記事の内容はこちらから

参照元について